Erőszak, meztelenség, bántalmazás, zaklatás… rengeteg dolog jöhet szembe velünk a Facebook hírfolyamába.

De azt már a legtöbben tudják, hogyan kell jelenteni egy Facebook oldalt, egy posztot, egy videót, vagy akár egy hirdetést, ha annak tartalma, vagy témája bántó.

De mi történik a jelentés után?

Hogy fordulhat elő, hogy például egy terrorista cselekményt bemutató videót engedélyeznek, egy régi háborús fotót nem? Aki már jelentett több témát, találkozhatott vele, hogy mennyire kiszámíthatatlan az eredmény. De miért van ez? Mi történik a jelentések után?

Többnyire emberek ellenőrzik egy bonyolult szabályzat alapján, amiről most egy kicsit többet megtudtunk, ugyanis a Guardian kezébe került több, mint 100 különböző dokumentum, köztük szöveges leírások, táblázatok, prezentációk.

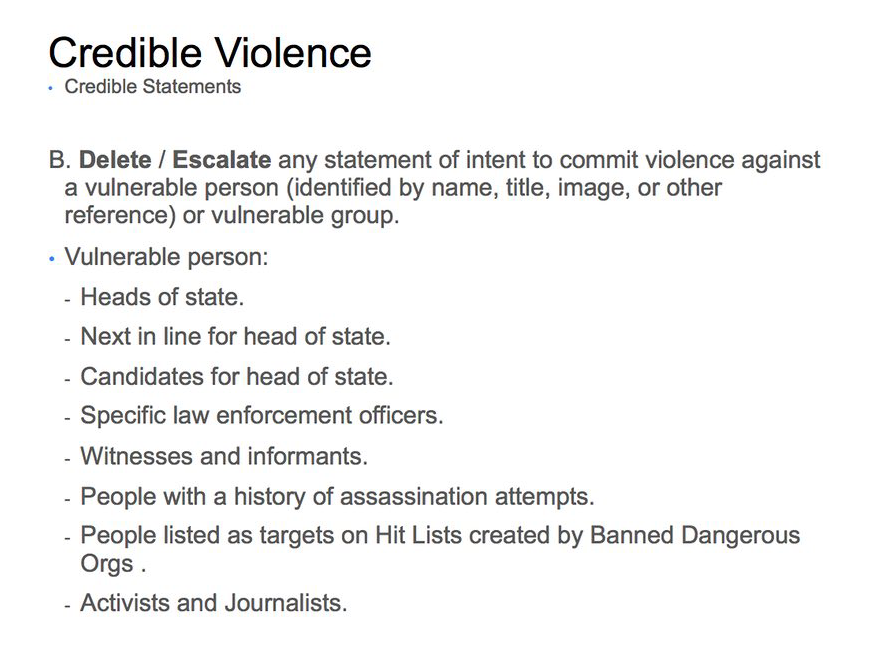

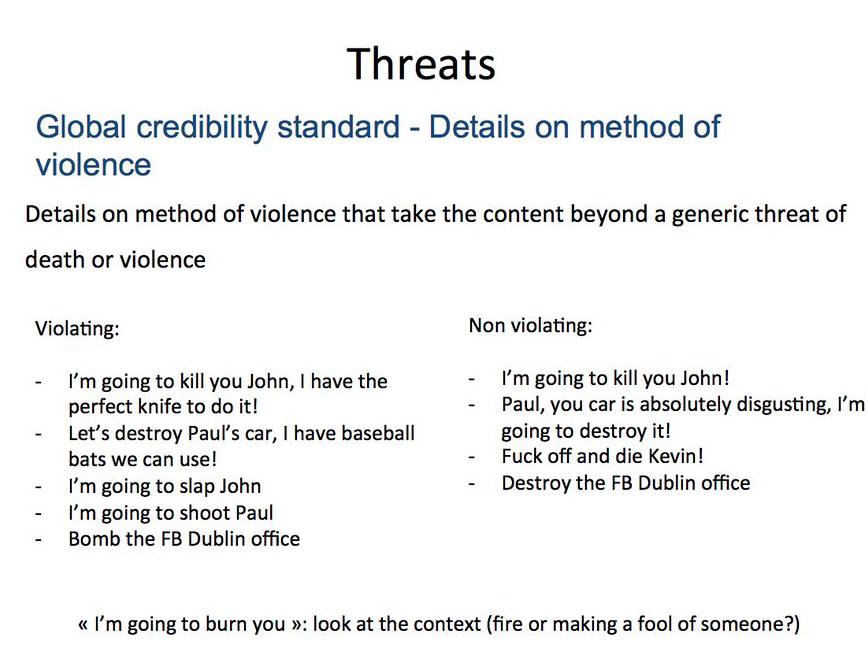

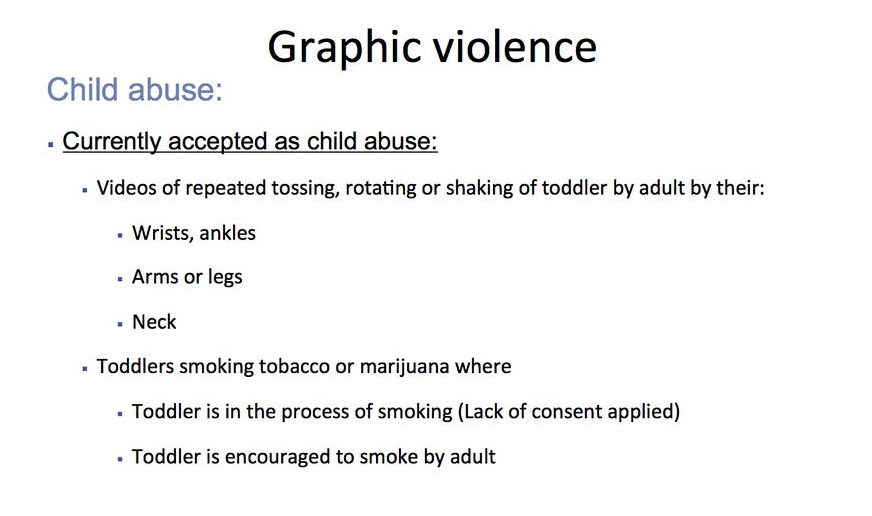

Ezek a Facebook ellenőrző csapatának adnak iránymutatást azzal kapcsolatba, hogy mit szabad engedélyezni, és mit nem. Itt található egy válogatás néhány meglepő elemmel. Például itt az erőszakos fenyegetések hihetőségét elemző prezentációt nézhetjük végig, itt a nem szexuális gyermekbántalmazással kapcsolatos irányelveket lehet végignézni, itt pedig az erőszakos ábrázolásokkal kapcsolatos részletes utasításokról van szó. Bármelyiket is nyitjátok meg, óvatosan, mert lehet, hogy fel fog zaklatni, amit ott találtok, pedig általában csak szövegek, példamondatok, amik segítenek eligazodni.

Elég részletesek az anyagok, bár csak egy töredéke annak, ami alapján dolgozniuk kell a moderátoroknak.

Néhány példa arról, hogy milyen bonyolult szempontok alapján épül fel a mostani moderálási rendszer:

– Az olyan megjegyzések, hogy “Valaki lője le Trumpot!” törlendők, mert az államfők védett kategóriába tartoznak. Ugyanakkor a “verjük meg a kövér gyerekeket”, vagy a “ahhoz, hogy eltörd a kurva nyakát, erősen nyomd középen a torkát” mondatok beleférnek.

Érdekes módon az elnökválasztási kampány során a jelöltek is védettséget kapnak, de csak ideiglenesen. Addig, amíg jelöltek.

– Erőszakos halált bemutató videókat, ha úgy vannak jelölve, mint zavaró tartalom, nem kell mindig törölni, hiszen ez segíthet felhívni a figyelmet egy problémára.

– Gyermekbántalmazással, nem szexuális jellegű gyermekek elleni erőszakkal kapcsolatos fotókat nem kell minden esetben törölni, vagy szankcionálni. Azonban ha szadisták, vagy ünneplik az erőszakot/bántalmazást, akkor igen.

– Állatok bántalmazását tartalmazó fotókat meg lehet osztani, csak az extrém módon felkavarókat kell zavarónak jelölni.

– Minden “kézzel készített” művészeti alkotás, ami meztelenséget tartalmaz mehet, de a digitálisan előállított alkotások nem.

– Abortuszról szóló videókat fel lehet tölteni, amíg azok nem tartalmaznak meztelenséget.

– Minden 100.000-nél több követővel rendelkező ember a közösségi platformon automatikusan közszereplőnek tekintendő. Ezzel viszont elvesztik azt a védettséget, amit a magánszemélyek élvezhetnek.

Ezek csak kiragadott elemek, azonban talán már ennyiből is látszik, hogy nem csak nehéz, gyakorlatilag lehetetlen feladat a közel 2 milliárd felhasználó által generált tartalmat átnézni, elemezni, értelmezni, és eldönteni, hogy mi az, ami belefér, mi az, ami nem.

Például csak olyan bejelentésből 6.5 milliót kapnak hetente, amik feltételezett kamuprofilokkal kapcsolatosak. A 4500 fős csapatnak nagyjából 10 másodperce van átnézni a jelentéseket. Nem véletlen, hogy néhány hete Mark Zuckerberg bejelentette, hogy újabb 3000 emberrel bővítik a moderátorok számát, plusz még a mesterséges intelligenciát is be fogják vetni a probléma kezelésére.

Ugyanakkor azt is elmondta Mark Zuckerberg korábban, hogy a jelenlegi keretek nem elég jók, hiszen nem lehet globálisan meghatározni olyan értékeket, amik egyformán jók a teljes közösségnek. Később egyfajta regionális irányelvekre számíthatunk, amiket a Facebook egyrészt a kulturális környezetünk, másrészt az ismerőseink viselkedése, harmadrészt a saját visszajelzéseink alapján fog elbírálni. Így próbálják meg elérni azt, hogy minden nagyobb csoport számára kellemes legyen a Facebook használat, de a különbségek ne legyenek zavaróak. Meglátjuk, hogy fog sikerülni.